輝達H200推論速度翻倍 明年Q2問世

鉅亨網記者魏志豪 台北

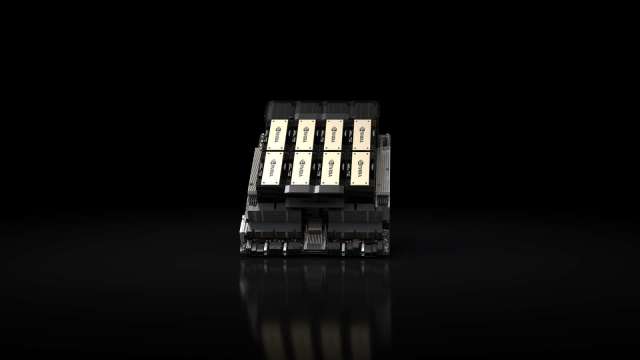

輝達 (NVDA-US) 推出最新 AI 晶片 NVIDIA HGX H200,成為首款搭載先進記憶體 HBM3e 的 GPU,將更快處理生成式人工智慧和高效能運算的大量資料,以同樣規模的語言模型計算,推論速度較前一代 H100 翻倍,預計全球系統製造商和雲端服務供應商將在明年第二季開始提供 NVIDIA H200。

輝達指出,HBM3e 速度更快、容量更大,可加速生成式人工智慧和大型語言模型,同時推進高效能運算工作負載的科學運算,NVIDIA H200 搭載 HBM3e 後,以每秒 4.8 TB 的速度提供 141GB 記憶體,與其前代 A100 相比,容量幾乎翻倍,頻寬增加 2.4 倍。

輝達超大規模與高效能運算部門副總裁 Ian Buck 表示,透過生成式人工智慧和高效能運算應用程式創造智慧,必須使用大型、快速的 GPU 記憶體來高速有效地處理大量資料。

輝達看好,H200 將進一步提升效能,相對於 H100,在 Llama 2 700 億參數大型語言模型上的推論速度將近翻倍提升,未來的軟體更新預計將為 H200 帶來額外效能的領先優勢,並持續最佳化 H200。

NVIDIA H200 將提供包含具有四路和八路配置的 NVIDIA HGX H200 伺服器主機板,其軟硬體皆與 HGX 100 系統相容。此外,NVIDIA H200 也可與今年 8 月推出、採用 HBM3e 的 NVIDIA GH200 Grace Hopper 超級晶片搭配使用。

NVIDIA 全球生態系合作夥伴伺服器製造商,包括永擎電子、華碩 (2357-TW)、戴爾科技集團、Eviden、技嘉 (2376-TW)、慧與科技、鴻佰科技、聯想、雲達科技、美超微、緯創 (3231-TW) 和緯穎 (6669-TW)。

明年包括亞馬遜網路服務、Google Cloud、Microsoft Azure 和 Oracle Cloud Infrastructure 也將成為第一批部署基於 H200 執行個體的雲端服務供應商。

- 美債、黃金、日元全倒 美元何以獨自挺立?

- 掌握全球財經資訊點我下載APP

延伸閱讀

- 輝達推出H200 迄今訓練AI模型的最快晶片

- 輝達推升級版AI晶片H200 亞馬遜、Google、甲骨文明年採用

- 美擬推AI晶片「全球許可制」 輝達、AMD出口恐都要華府點頭

- 輝達GTC大會3月中登場!SK海力士掌門人將首次出席 再會黃仁勳談HBM4與AI半導體合作

- 講座

- 公告

上一篇

下一篇