深偽詐欺已騙走8億台幣! KPMG傳授兩大秘器 防止被AI影片耍了

鉅亨網記者張韶雯 台北

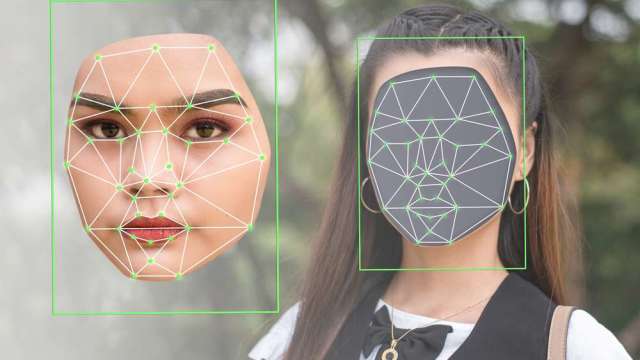

AI 熱潮方興未艾,已有多起犯罪集團利用 AI 人像來欺騙銀行的面部識別系統成功詐貸; 或針對跨國公司進行詐騙,損失超過新台幣 8 億,KPMG 安侯建業指出,要防止被 Sora 等 Al 影片欺騙 · 必須有「提升 AI 風險素養」及「建構 AI 內容的透明度與可識別度」等兩大防禦策略。

隨著「一句話創造一分鐘 Al 高畫質影片」的 Sora 平台示範影片出爐, 不但影視創作產業受到巨大震撼, 更隱藏著潛在的資安風暴。Sora 橫空出世,只要幾個簡單的提示詞, 即可生成 4K 超高質影片, 甚至達到專業人士難以分辨真偽的程度。

KPMG 安侯建業顧問部營運長謝盷澤表示,過去大家擔心會有超越專家能力的「超級人工智慧 (Super Al)」,但是「超級深偽 (Super Depfake)」 欺詐技術,已伴隨網路 AI 影音服務出現 · 才更令人憂心。若無適當的風險控制,很可能形成「深偽即服務 (Deepfake as a service) 」的暗黑產業鏈。未來恐被用來製造更真偽難辨的假新聞,對公眾意識形態的選舉、乃至國家安全,都構成前所未有的挑戰, 連目前採用的如遠距身分識別等機制, 都可能被撼動。

KPMG 依據近期資安情資分析,已有多起犯罪集團利用深偽技術生成的 AI 人像來欺騙銀行的面部識別系統進行詐貸; 多宗利用深偽技術針對跨國公司進行詐騙的事件,造成至少 8 億台幣的損失,顯示以 AI 深偽技術結合傳統詐騙手法的「新智慧詐騙工程」正在蔓延。

謝盷澤強調,要防止被 Sora 等 Al 影片欺騙 · 必須有「提升 AI 風險素養」及「建構 AI 內容透明度與可識別度」等兩大防禦策略。他建議,首先要顛覆過去對網路影音「有片有真相」的認知, 以後要轉變為「保持懷疑 ,確信來源」,才能夠在生成式 Al 普及的網路世界中 ,具備基本的「防深 (偽) 術」。

其次,針對應用生成式 Al 提供服務的業者,未來的資安不只要重視傳統的「機密性」,並要將產出成品提供「透明的告知或識別」,讓使用者可以輕易分辨內容是源自 AI,且要能夠對真實性加強驗證,建構足夠的防偽機制,例如:在原始的影音檔案中添加雜訊或浮水印,來阻擋超級深偽的偽冒或複製。企業在高風險的網路交易中, 建議以零知識證明 (Zero-knowledge proof, ZKP) 不透露使用者 自身資訊等新型密碼學技術來進行身分認證。

謝盷澤指出,生成式 AI 究竟會成為未來眼球經濟的「沈浸式利器」,還是「沉沒式利刃」? 關鍵就在於自身的資安防禦能力是否足夠強大。

延伸閱讀

- OpenAI最新Sora模型背後:成立不到1年的核心團隊打造

- Sora推出後 Altman共同創立的加密貨幣價格飆升

- 【新台股龍捲風】Nvidia+Fed會是利多出盡嗎?Sora概念股訊芯2根漲停! 設備、記憶體、重電伺機!

- 短短一句話就能生成影片,Sora再掀AI熱潮!Sora概念股一文看懂

- 講座

- 公告

上一篇

下一篇